best-practices datacenter fabric a confronto tra fabricpath vs trill vs lisp vs qfx5100 vs aci

21.12 2019 | by massimilianoQuesto documento mette in evidenza alcune best-practices datacenter fabric clos tra differenti modelli quali fabricpath, trill, lisp, QFX5100 Fabric ed […]

https://www.ingegnerianetworking.com/wp-content/uploads/2019/12/FP-cisco-fee.png

Questo documento mette in evidenza alcune best-practices datacenter fabric clos tra differenti modelli quali fabricpath, trill, lisp, QFX5100 Fabric ed ACI

I vantaggi di una architettura spine-leaf clos possono riassumersi in:

- architettura a due livelli a costruire una Fabric Switch (unico dominio)

- alta scalabilità (possibilità di inserimento nuovi elementi) ed una grande capacità in numero di porte

- riduzione OpEx (es: riduzione numero apparati rispetto ad una tradizionale rete a tre livelli)

- riduzione CapEx (es: risparmio energetico)

- spanning Tree Free

- L3 Ethernet equal-cost multipath (ECMP Load Balancing)

- avere funzionalità L2 (switching) attraverso L3 capability IPv4 e IPv6 (oltre MPLS, BGP, ISIS), inoltre supporta funzionalità quali FCoE, VXLAN, NVGRE, VMware integration

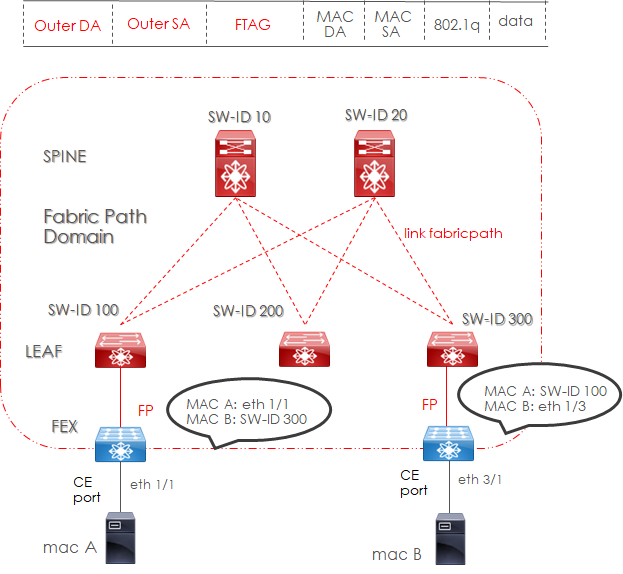

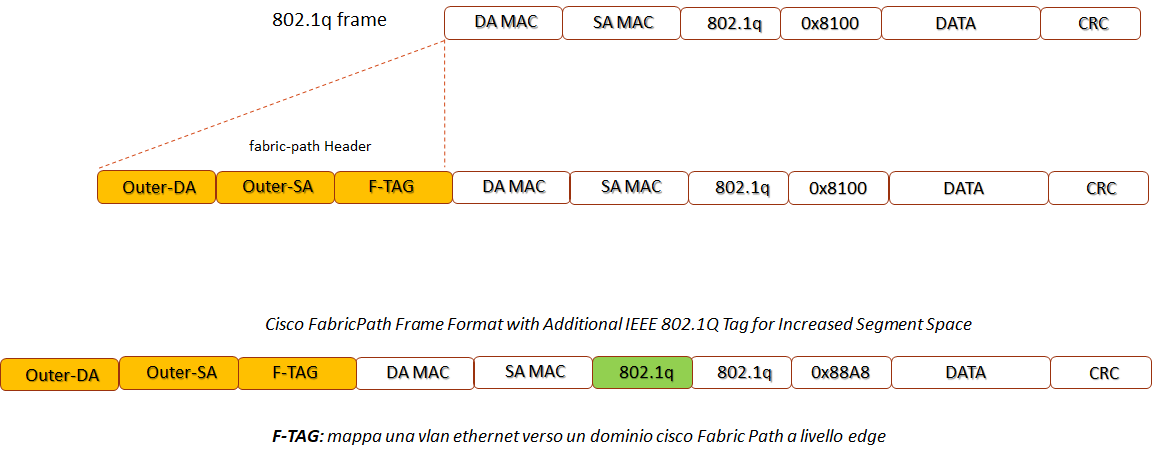

1) Modello FabricPath

- – FabricPath è una tecnologia Cisco con Nexus devices a livello di accesso, distribuito all’interno di un solo datacenters

- – le frame FP è usata per incapsulare standard frame ethernet per attraversare un dominio fabricpath, basato su un nuovo header chiamato Switch-ID

- – ISIS underlay routing protocol è utilizzato per lo scambio di informazioni riguardo la raggiungibilità degli switch-ID

- – usando SPF (Shortest Path First ), ISIS permette l’uso di multipli equal-cost path tra due end-points FP

- – utilizzo della tecnologia vPC enhanced tra peers FP spine and leaf (IEEE802.3ad)

- – FP utilizza multidestination tree per trasmettere pacchetti broadcast, multicast e unknown unicast frame

- – da un punto di vista di un edge-switch (è uno switch che permette connessioni FP e STP) tutto il dominio FabricPath è visto come un solo Virtual STP bridge

- – FTAG descrive e segmenta un multipath mappando una frame ethernet con vlan-id ad una specifica topologia FP a livello edge-switch

FTAG HEADER:

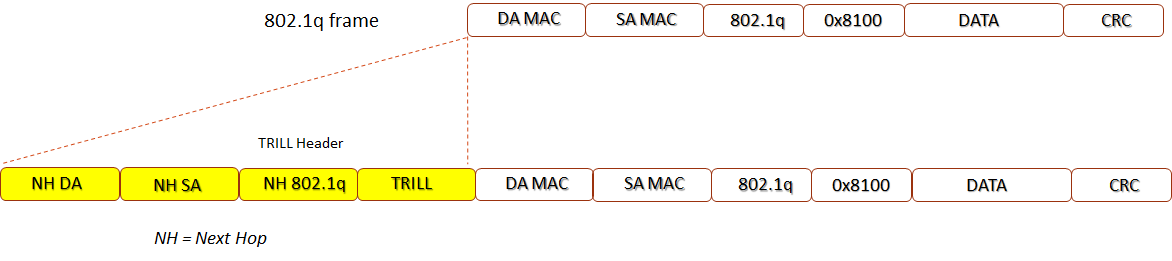

2) Modello Trill Transparent Interconnection of Lots of Links:

- – TRILL è una tecnologia L2 multipath a livello di accesso (come FabricPath)

- – è implementato da devices conosciuti come RBridge (routing bridges) che aggiunge un nuovo encapsulation in modo incrementale, ripetendo l’originale IEEE 802.3 ethernet frame che può passare attraverso intermediate Router Bridge.

- – TRILL utilizza ISIS come underlay per lo scambio di informazioni di controllo e raggiungibilità tra end-points RB, calcolando il miglior percorso per pacchetti unicast e calcolare un albero di distribuzione (distribution tree) per destinazioni multiple di frame.

- – le informazioni di un End-Host possono essere apprese attraverso il protocollo ESADI (End-Station Address Distribution Information) le cui frame sono regolarmente encapsulate in TRILL frame

- – TRILL può usare un massimo di 4000 segmenti di rete (vlans)

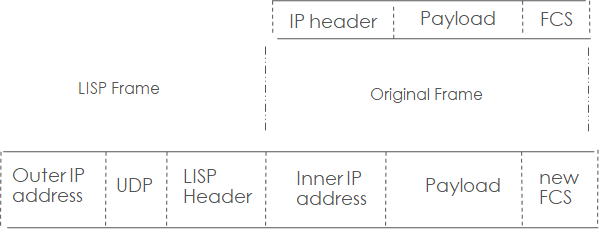

3) Modello lisp (locator / identifier separation protocol)

- – LISP è progettato per ambienti datacenter dove è previsto un moving di un end-point ed i suoi parametri di rete (addressing) non cambiano ma semplicemente la sua locazione

- – RLOC (Routing Locators): descrive la topologia e locazione di un end-point e quindi è usato questo parametro per trasmettere traffico

- – EID (End-Point ID): è utilizzato per indirizzare end-points separati dalla topologia della rete

- – ITR (Ingress Tunnel Router) and ETR (Egress Tunnel Router): sono i devices che operano encapsulation (ingress) ed de-encapsulation (egress) di pacchetti IP-based EID attraverso una IP Fabric

- – LISP è conosciuto come una tecnologia Layer 3 che comprende IPv4 e IPv6 per overlay e underlay

- – LISP assicura virtual segmenti di rete (vlans) aggiungendo un header di 24 bit instance-id che permette di estendere sino a più di 16 milioni di virtual segment; questo meccanismo è settato dal ITR.

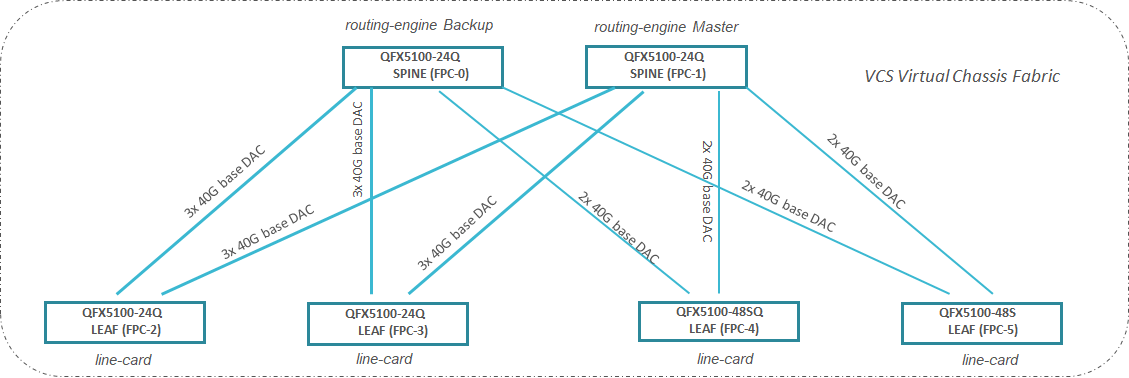

4) Modello QFX5100 juniper Fabric

- – La Fabric opera in modalità VCF (Virtual Chassis Fabric) in cui tutti gli switch della Fabric si aggregano a formare logicamente un unico switch L2/L3 nel contesto del quale i due apparati di Spine assolvono il ruolo di routing engine (active/standby) e i nodi Leaf operano concettualmente come linecard.

- – La Fabric consente l’aggregazione di più porte fisiche, anche di switch differenti, in gruppi LACP; ciò a scopo di distribuzione del traffico su più interfacce e di alta affidabilità ai guasti.

E’ un’architettura CLOS (Spine and Leaf) dove le principali features sono:

- Fabric multi-path: il piano di forwarding di un pacchetto tra i nodi è regolato dal protocollo SPF (Shortest Path First);

- Intelligent Bandwidth Allocaton: il nodo trasmittente considera la quantità di banda disponibile per ogni multi-path tra un nodo e l’altro, allocando le risorse di rete end-to-end;

- Bidirectional MDT (Multicast Distribution Tree): VFC calcola multipli alberi (tree) multicast in modo bidirezionale e performa load-balancing in questi percorsi;

- L2 and L3 capability: in base alla licenza adottata, possiamo avere funzionalità L2 attraverso L3 capability IPv4 e IPv6 (oltre MPLS, BGP, ISIS in tutte le porte VFC), inoltre supporta funzionalità quali FCoE, VXLAN, NVGRE, VMware integration;

- Resiliency and High Availability: include redundant routing engine in modalita active-backup, redundant data-plane con modalità active-active uplinks;

- NSSU (No Stop Software Upgrade): disponibile per VFC con doppio RE (Routing Engine) e consente aggiornamenti software senza distruzioni o interruzioni di funzionalità.

Sono possibili due configurazioni VCF:

- – Preprovisioned: con il controllo di ciascun nodo assegnando un member-ID ed il ruolo a lui assegnato;

- – Non-provisioned: è il nodo master che assegna un member-ID a ciascun nodo; il ruolo è determinato dal valore di priority masterschip ed altri fattori che concorrono alla elezione del master;

- – Master Routing Engine: il nodo master RE controlla tutta la Fabric VCF

- – Backup Rouing Engine: il nodo di backup RE resta in standby mode con un kernel (cuore del sistema) e lo stato dei protocolli in uso sincronizzato rispetto al nodo master

- – Line-card: a parte I nodi master e backup, tutti gli altri nodi della VFC hanno ruolo di line-card.

- Il collegamento di sistemi hardware e software come bilanciatori e firewalls per ambienti datacenter debbono essere collegati su QFX5100 aventi ruolo di line-card

Vedi esempio di configurazione:

https://www.massimilianosbaraglia.it/application/17-clustering/switch/4-cluster-qfx5100-juniper

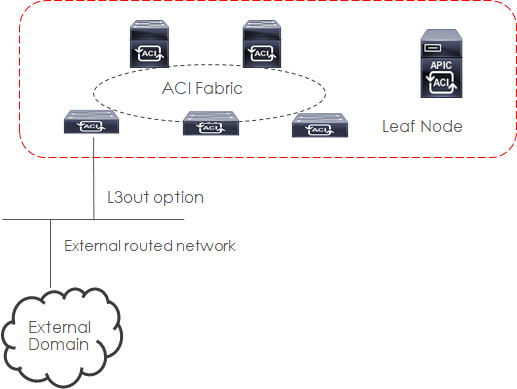

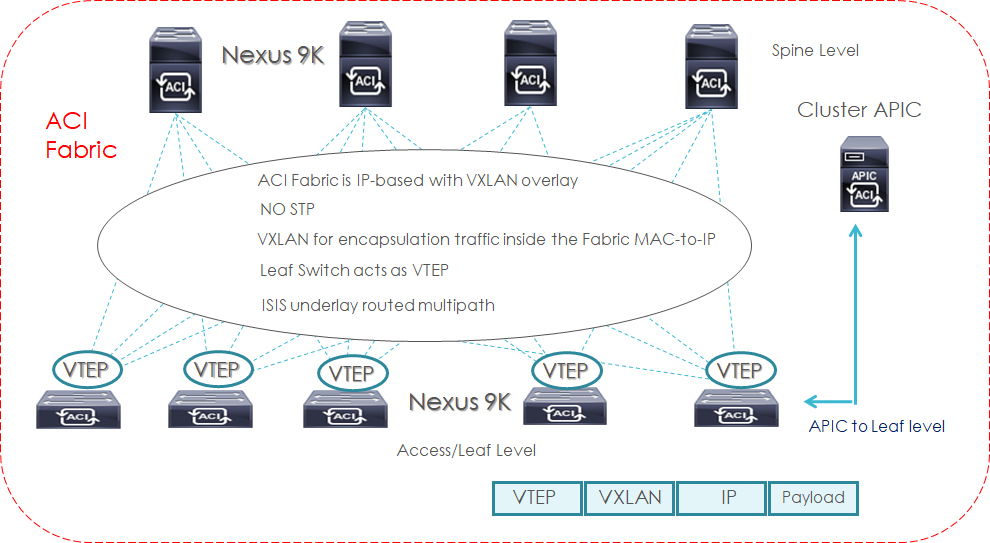

5) Modello ACI Cisco Fabric

Cisco ACI (Application Centric Infrastructure) è basato sul concetto di group-based policy SDN;

End-User ACI può definire una serie di regole senza la conoscenza e/o informazioni che derivano dalla struttura networking;

Cisco APIC (Application Policy Infrastructure Controller) è responsabile della gestione centralizzata delle policies configurate e distribuirle a tutti i nodi facenti parte della ACI Fabric;

Cisco ACI è disegnato per scalare in modo trasparente nei confronti di cambiamenti di connettività, bandwidth, tenants e policies; la sua architettura è di tipo spine-leaf che si presta efficientemente a introdurre e/o cambiare requisiti di rete;

Cisco ACI include servizi layer 4 to layer 7, APIs (Application Programming Interface), virtual networking, computing, storage resources, wan routers, orchestration services.

Cisco ACI consiste in:

– Un insieme di software e hardware devices che costituiscono una Fabric

– APIC per la gestione delle policies centralizzata

– AVS (Application Virtual Switch) per virtual network edge level

– Integrazione di fisiche e virtuali infrastrutture

- Un aperto ecosistema di network, storage, management e orchestration vendor

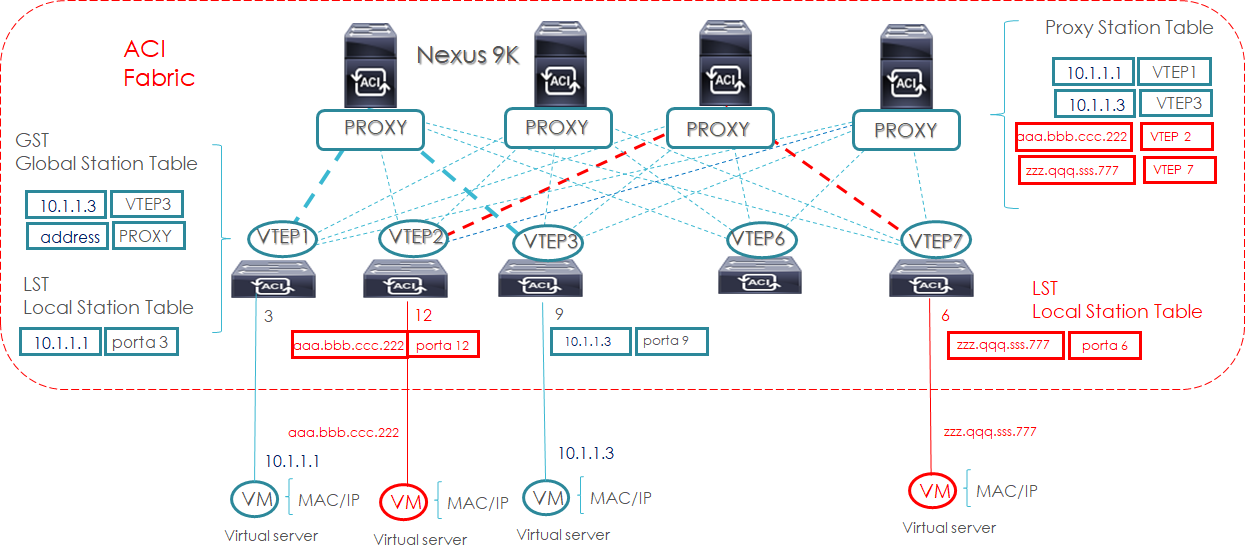

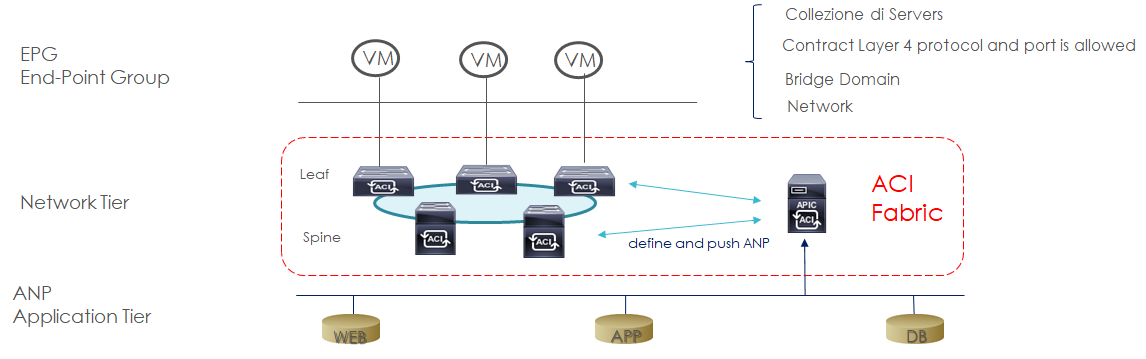

esempio grafico di aci control-plane with mapping database:

esempio di aci policy-based:

Cisco APIC (Application Policy Infrastructure Controller): è responsabile della gestione centralizzata delle policies configurate e distribuirle a tutti i nodi facenti parte della ACI Fabric;

ANP (Application Network Profile): contiene le policies dei sistemi applicativi;

EPG (End Point Group): consiste di un numero di end-point groups rappresentati da uno o più servers all’interno di uno stesso segmento di rete (vlans)

Contract: consiste di policies che definiscono il modo con cui comunicano tra loro gli EPG.

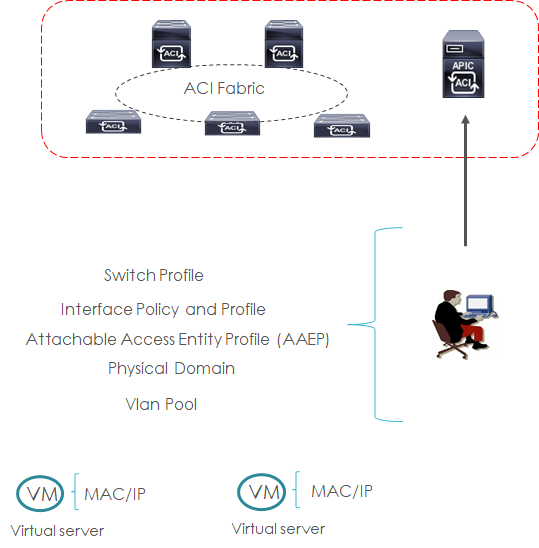

esempio di aci access-policy:

- – vlan pool: definisce un singolo segmento di rete (vlan) oppure un pool di vlans

- – physical Domain: definisce un dominio (scopo) dove è creato il vlans pool

- – AAEP (Attachabe Access Entity Profile): definisce un modo di raggruppare multipli domini applicabili ad un profilo su base interfaccia

- – interface Policy and Profile: questa policy definisce i parametri richiesti come può essere un LLDP, LACP, etc; contiene la interface policy e specifica a quale port number deve essere applicata usando la port-selector

- – switch profile: applica il profilo su base interfaccia con la policy associata ad uno o più multiple access Leaf Nodes

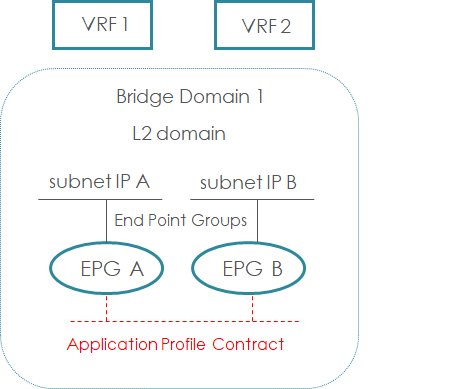

esempio di aci fabric layer 2 steps di configurazione

- – VRF instances

- – BD (Bridge Domain) associato alla VRF instance (senza abilitare nessun layer 3 IP SVIs subnet)

- – Configurazione del Bridge Domain per ottimizzare la funzionalità di switching (hardware-proxy-mode) usando il mapping database oppure il tradizionale flood-and-learn

- – EPG (End Point Group) relazionandoli ai bridge domain di riferimento; possiamo avere multipli EPG associati allo stesso bridge domain

- – Creare policy Contracts tra EPG come necessario; possiamo anche considerare una comunicazione tra diversi EPG senza ausilio di filtri, settando la VRF instance in modalità < unenforced >

- – Creare access policies switch e port profiles assegnando i parametri richiesti, associate al nodo Leaf di pertinenza

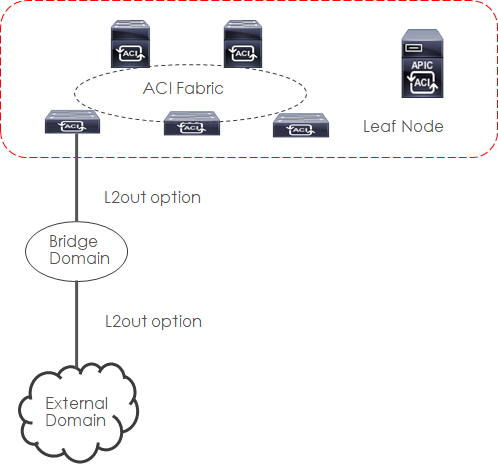

esempio di aci fabric layer-2 steps di configurazione extending to external domain

- – Enable fllooding of layer 2 unknown unicast

- – Enable ARP flooding

- – Disable unicast routing (può essere abilitato successivamente ad una fase di migrazione ad esempio se gli end-point usano come IP gateway il sistema ACI Fabric

- – L2Out option provvede ad una L2 extension da ACI Fabric ad un External domain bridged network

esempio di aci fabric layer-3 steps di configurazione extending to external domain:

- – Layer 3 interface routed: usata quando si connette un determinato external devices per tenant /VRF

- – Subinterface with 802.1q tagging: usata quando vi è una connessione condivisa ad un determinato external devices attraverso tenants/ VRF-lite

- – Switched Virtual Interface (SVI): usata quando entrambi i layer L2 ed L3 di connessione sono richiesti sulla stessa interfaccia

- – La propagazione di external network all’interno di un dominio ACI Fabric utilizza il MP-BGP (Multi Protocol BGP) tra Spine e Leaf (si può avere anche la funzionalità di Route Reflector abilitato a livello Spine) all’interno di un unico AS

- Create un external routed network:

- Set a layer 3 border leaf node for the L3 outside connection

- Set a layer 3 interface profile for the L3 outside connection

Da ripetere i suddetti passi in caso di più leaf/port

- Configurare un external EPG (ACI Fabric mappa the external L3 router to the external EPG usando la IP prefix and mask)

- Configurare un contract policies tra external and internal EPG (senza il contratto la connettività verso l’esterno non sarebbe possibile)